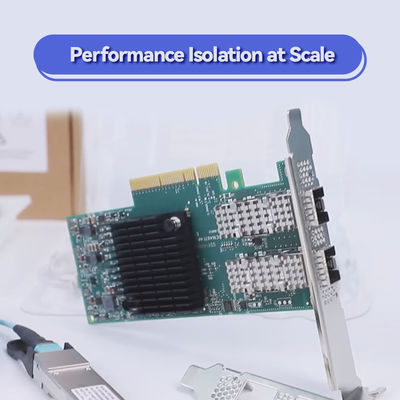

100 g HDR Infiniband Mellanox 100 gb Nic Netzwerkoberfläche QSFP56 MCX653106A-ECAT

Produktdetails:

| Markenname: | Mellanox |

| Modellnummer: | MCX653106A-ECAT |

| Dokumentieren: | connectx-6-infiniband.pdf |

Zahlung und Versand AGB:

| Min Bestellmenge: | 1pcs |

|---|---|

| Preis: | Negotiate |

| Verpackung Informationen: | Äußere Box |

| Lieferzeit: | Auf der Grundlage der Bestände |

| Zahlungsbedingungen: | T/t |

| Versorgungsmaterial-Fähigkeit: | Versorgung nach Projekt/Batch |

|

Detailinformationen |

|||

| Produktstatus: | Aktie | Anwendung: | Server |

|---|---|---|---|

| Technologie: | Infiniband | Übertragungsrate: | 100gbe |

| Typ: | Drahtlos | Art: | Extern |

| Schnittstellentyp: | Infiniband | Wifi Adapte: | Drahtlos |

| Anschlusstyp: | QSFP56 | Ports: | Dual |

| Hervorheben: | Mellanox 100gb HDRs Infiniband NIC,QSFP56 mellanox 100gb NIC,NIC-Netzwerkschnittstelle HDRs Infiniband |

||

Produkt-Beschreibung

NVIDIA ConnectX-6 MCX653106A-ECAT InfiniBand Netzwerkkarte

Premium-Performance-Netzwerklösung

Die NVIDIA ConnectX-6 MCX653106A-ECAT stellt einen Durchbruch in der Netzwerk-Interface-Card-Technologie dar und liefert außergewöhnliche 200 Gbit/s Bandbreite pro Port durch fortschrittliche InfiniBand-Architektur. Diese hochmoderne NIC-Karte integriert hochentwickelte In-Network-Computing-Funktionen, die die Rechenzentrumsleistung grundlegend verändern, indem sie kritische Verarbeitungsprozesse von Host-CPUs entlasten. Dieser ConnectX-6-Adapter wurde für die anspruchsvollsten Rechenumgebungen entwickelt und bietet beispiellosen Durchsatz, extrem niedrige Latenz und erweiterte Sicherheitsfunktionen, die ihn ideal für Rechenzentren der nächsten Generation, Infrastrukturen für künstliche Intelligenz und Hochleistungs-Computing-Cluster machen.

Hauptmerkmale

Hochgeschwindigkeitskonnektivität

Dual-Port 200 Gbit/s InfiniBand- und Ethernet-Konnektivität mit extrem niedriger Latenz und hoher Nachrichtenrate

Erweiterte Offload-Technologie

Hardwarebeschleunigtes RDMA, NVMe over Fabrics und Verschlüsselungsverarbeitung

Erweiterte Sicherheit

Block-Level XTS-AES 256/512-Bit Hardware-Verschlüsselung mit FIPS-Konformität

Virtualisierungsbereit

SR-IOV-Unterstützung mit bis zu 1.000 virtuellen Funktionen für Multi-Tenant-Umgebungen

Technische Daten

| Spezifikation | Details |

|---|---|

| Produktmodell | MCX653106A-ECAT |

| Schnittstellentyp | Dual-Port QSFP56 |

| Datenrate | 200 Gbit/s pro Port |

| Host-Schnittstelle | PCIe 4.0 x16 |

| Protokollunterstützung | InfiniBand HDR, Ethernet |

| RDMA-Technologie | RoCE v2, InfiniBand RDMA |

| Sicherheit | XTS-AES 256/512-Bit-Verschlüsselung |

| Virtualisierung | SR-IOV (1000 VFs) |

| Formfaktor | Standard-PCIe |

| OS-Unterstützung | Linux, Windows, VMware |

Anwendungen

- ✓ Hochleistungs-Computing-Cluster

- ✓ Künstliche Intelligenz & maschinelles Lernen

- ✓ Cloud-Rechenzentren & Hyperscale-Umgebungen

- ✓ Big-Data-Analytik & Speichernetzwerke

- ✓ Finanzdienstleistungen & Hochfrequenzhandel

- ✓ Virtualisierte Infrastruktur & NFV

Häufig gestellte Fragen

Welche Systeme sind mit dieser Netzwerkkarte kompatibel?

Die ConnectX-6 NIC-Karte ist mit Servern kompatibel, die über PCIe 3.0- oder 4.0 x16-Steckplätze verfügen, und unterstützt gängige Betriebssysteme wie Linux, Windows Server und VMware ESXi.

Unterstützt dieser Adapter sowohl InfiniBand als auch Ethernet?

Ja, diese vielseitige Netzwerkkarte unterstützt sowohl InfiniBand- als auch Ethernet-Protokolle und bietet Flexibilität für unterschiedliche Infrastrukturanforderungen.

Welche Vorteile bietet die Hardware-Verschlüsselung?

Die integrierte XTS-AES-Verschlüsselungs-Engine bietet Sicherheit mit Leitungsgeschwindigkeit, ohne die Leistung zu beeinträchtigen, und gewährleistet den Datenschutz ohne Durchsatzverluste.

Wie profitiert diese NIC-Karte von KI-Workloads?

Die ConnectX-6-Netzwerkkarte beschleunigt das KI-Training, indem sie eine hohe Bandbreite und Konnektivität mit geringer Latenz zwischen GPUs und Speichersystemen bereitstellt und die Trainingszeiten erheblich verkürzt.

Unternehmensvorstellung

Mit über einem Jahrzehnt Branchenerfahrung hat sich unser Unternehmen als führender Anbieter von fortschrittlichen Netzwerklösungen etabliert. Wir betreiben umfangreiche Produktionsstätten, die von einem hochqualifizierten technischen Team mit fundierter Expertise in Hochleistungs-Netzwerktechnologien unterstützt werden. Unser umfassendes Produktportfolio umfasst führende Marken wie Mellanox (jetzt NVIDIA Networking), Ruckus, Aruba und Extreme Networks und bietet originale, fabrikneue Netzwerkausrüstung, darunter Switches, Netzwerkkarten, Wireless Access Points, Controller und strukturierte Verkabelungslösungen.

Unser Bestandsverwaltungssystem verwaltet über zehn Millionen Einheiten auf Lager und gewährleistet sofortige Verfügbarkeit und Volumenversorgungskapazität für Unternehmens- und Rechenzentrumseinsätze. Wir bieten rund um die Uhr Kundensupport und technische Beratungsdienste, unterstützt von einem professionellen Engineering-Team, das unseren Ruf für Zuverlässigkeit und Fachwissen in globalen Märkten begründet hat. Unser Engagement für Qualität, wettbewerbsfähige Preise und technische Exzellenz hat uns zu einem bevorzugten Partner für Organisationen weltweit gemacht, die eine hochmoderne Netzwerkinfrastruktur implementieren möchten.